L’architecture de l’infrastructure numérique, entre le mythe et la réalité

Il n’y a pas réellement une architecture de l’industrie numérique comme existait une architecture de l’électricité et du ferroviaire.

Pour les datacenters en tout cas, la rapidité de développement de l’Internet a favorisé, des choix d’implantation très opportunistes et parfois mal anticipés.

Avec comme principal objectif, la rapidité de mise en oeuvre et la rentabilité de la construction. Voilà une vision architecturale purement économique et technologique.

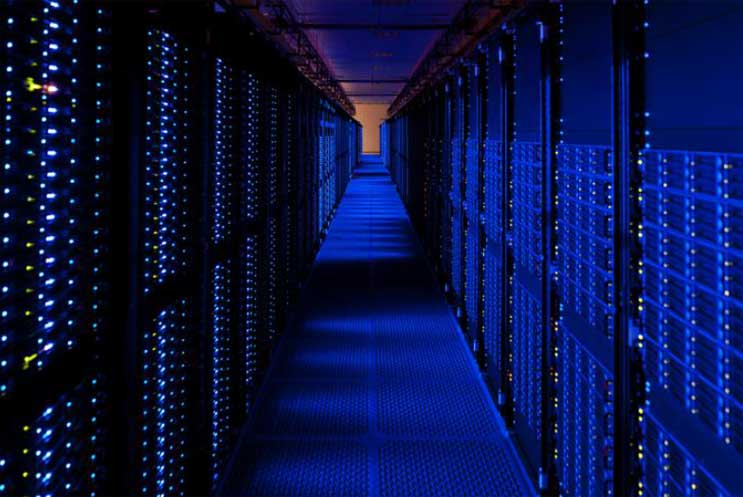

La typologie des bâtiments des datacenters est peu variée. Elle est liée à l’histoire fulgurante de leur déploiement.

L’histoire foncière des premiers centres de données : transformation des centrales téléphoniques.

Les premiers datacenters s’installaient souvent au cœur des villes, dans les anciens bâtiments des centrales téléphoniques ou de l’industrie électronique.

Les premiers datacenters s’installaient souvent au cœur des villes, dans les anciens bâtiments des centrales téléphoniques ou de l’industrie électronique.

Citons par exemple les locaux d’Orange à Paris, les tours d’anciens sièges de AT&T, NY Telephone company et de Verizon à New York. De même, on peut rappeller les centres à Hillsboro près de Portland et à Santa Clara.

Cette première génération urbaine et périurbaine exploitait les caractéristiques des bâtiments conçus pour supporter de lourdes charges.

Ils bénéficiaient des conditions déjà existantes de sécurité et de connectivité.

L’histoire foncière des datacenters de cette première génération était ainsi liée à la transformation d’anciens bâtiments urbains.

Deuxième génération, l’âge des « boîtes à chaussures ».

Le déploiement rapide de la technologie cloud dans la dernière décennie, aiguise l’appétit des investisseurs immobiliers. Voici un formidable potentiel du retour sur investissement rapide.

Ainsi démarre la période de la « boîte à chaussures ». Ce qui compte est de rentabiliser vite la charge liée à la construction neuve. Les fonds, comme Digital reality, CoreSite ou Equinix financent dans une logique “quick winn” une architecture-entrepôt. Le but principal n’est pas de créer un bâtiment remarquable.

Cette architecture insipide se trouve encore dans les premiers datacenters de Google à Oregon ou chez Amazon Web Services au nord de Virginie.

Aujourd’hui, 23 centres y sont répertoriés près du hub d’Ashburn et de Sterling avec une capacité de 500MW.

Un début d’effort d’intégration dans l’environnement péri-urbain

L’intégration architecturale et paysagère commence avec les datacenters de Facebook et d’Apple à Prineville, d’Adobe à Hillsboro, de Coresite à Santa Clara ou d’Equinix à Dallas.

En France on peut citer l’effort du site d’Orange à Val-de-Reuil.

En France on peut citer l’effort du site d’Orange à Val-de-Reuil.

En France, de nombreux centres ‘entrepôts’ se trouvent concentrés sur la plaine au nord de Paris, le long de l’autoroute A1. Citons la Courneuve avec le Datacenter d’Interxion , juste en face de petits pavillons de banlieue. D’autres centres se trouvent à Vitry, aux Ulis, à Aubervilliers et à Saint-Denis.

Pourquoi une telle polarisation métropolitaine ?

Un datacenter du point de vue d’un investisseur est un produit immobilier à haute rentabilité financière. Sa localisation est au cœur de sa valeur.

Les datacenters ne sont pas construits dans des espaces isolés. Pourquoi? Il se trouve qu’ils nécessitent des connexions rapides et puissantes aux fibres.

En effet, ils doivent aussi bénéficier de la proximité d’un important bassin d’utilisateurs et, si possible, de conditions climatiques favorables.

Ils sont donc naturellement concentrés autour des hubs de l’Internet et des réseaux de fibres.

Les raisons de la concentration des sites

Les quatre principaux pôles européens de concentration des datacenters sont Frankfort, Londres, Amsterdam et Paris.

Aux États-Unis c’est évidemment à la Silicon Valley, au nord de la Virginie, près de Washington et près de New York.

La ville comme Santa Clara dénombre plus de 50 sites de stockage de données.

Cette densité d’infrastructure explique aussi pourquoi désormais Amazon se réoriente vers l’état d’Oregon.

On constate désormais pour les géants américain un double système d’exploitation. Des datacenters européens proches des utilisateurs pour les contenus à partage immédiat. Puis, un archivage pour d’autres datas moins consultés sur des serveurs aux États-Unis.

Une opportunité de désenclavement rural?

Rares sont donc de grands datacenters en zone rurale. Sauf si une fibre privée rapide, pour compenser l’éloignement physique, a été mise en place. C’est par exemple le cas de Facebook à Oregon.

Rares sont donc de grands datacenters en zone rurale. Sauf si une fibre privée rapide, pour compenser l’éloignement physique, a été mise en place. C’est par exemple le cas de Facebook à Oregon.

Un datacenter isolé comme Taho-Reno n’est pas du tout représentatif du phénomène global des implantations.

Voilà donc une nouvelle pierre à l’édifice de la course à la concentration péri-urbaine et à la désertification rurale.

Impact écologique des datacenters

Les datacenters représenteront les plus importants postes de consommation électrique de notre siècle.

En parlant des réseaux numériques et du virtuels, on oublie parfois qu’il s’agit aussi des infrastructures physiques. De surcroît, l’impact écologique n’est pas neutre.

En parlant des réseaux numériques et du virtuels, on oublie parfois qu’il s’agit aussi des infrastructures physiques. De surcroît, l’impact écologique n’est pas neutre.

Avec le flux de données qui augmente de 25% chaque année, la consommation énergétique des datacenters est un sujet sensible.

En 2013, le secteur informatique (réseaux, matériel et datacenters) consommait environ 7% de l’électricité mondiale. Les prévisions parlent de plus de 50% à l’horizon de 2030.

Ces infrastructures sont majoritairement intégrées dans les cercles d’échanges des villes, dont ils modifient sensiblement la consommation de l’énergie.

Certaines acteurs cherchent à devenir énergétiquement autonomes.

Les Big TECH investissent ainsi dans les filiales énergétiques (Apple Energy, Microsoft avec Microgrid investment Accelerator ou encore Facebook).

La « Smart city » est -elle porteuse d’un potentiel de renouvellement de l’architecture y compris de ces « objets-datacenters » ?

Il faut sans doute distinguer deux logiques dans la mise en œuvre de l’habitat augmenté et de la ville intelligente :

- l’intégration dans les villes existantes,

- la création de villes nouvelles.

La Smart city est caractérisée par l’intégration d’une logique d’analyse comportementale appliquée à l’urbanisme. C’est une infrastructure à technologie assez invisible.

La Smart city est caractérisée par l’intégration d’une logique d’analyse comportementale appliquée à l’urbanisme. C’est une infrastructure à technologie assez invisible.

Il s’agit avant tout des outils analytiques orientés vers la prévision, la prédiction et la prescription à partir de données et de calcul.

Ajoutons à cela ensuite la démultiplication des dispositifs de capteurs pour le projet de la ville ‘augmentée’. Un projet (ou un mythe) de la ville intelligente reste avant tout un projet de captation et optimisation de flux de données.

La partie visible, physique, de cette technologie liée au numérique sont des infrastructures sans architecture remarquable.

Les perspectives d’apparition de nouveaux espaces et de nouveaux usages

Une autre logique urbanistique et architecturale émergera sans doute uniquement dans des projets de création de villes augmentées nouvelles. A l’image du projet de création de quartier Quayside à Toronto. Nous consacrons un article complet au sujet.

Un changement important viendra de la gestion améliorée des flux de trafic. La disparition des parkings et des grandes routes encombrées modifierait sensiblement les espaces de la ville. Si l’apparition massive de l’usage des véhicules personnels au 20 ème siècle a éclaté la ville en zones spécialisées, nous pouvons espérer qu’un phénomène inverse se produise dans une nouvelle smart city.

La façon d’organiser les espaces pourrait radicalement changer. Cette cité optimisée pourrait apporter de nouveaux usages, qui se développeront dans de nouveaux lieux de vie.

Notons, que le principal projet de l’architecture augmentée à l’échelle d’un nouveau quartier, se trouve dans les mains d’une filiale de Google (Sidewalk lab). Nous pouvons aussi citer les expérimentations de Masdar City (près d’Abou Dabi)..

Quelles nouvelles pistes se dessinent autour de la construction des datacenters à l’avenir ?

Nous avons en Europe des villes anciennes et denses. Ceci implique une certaine façon de réfléchir à l’intégration de l’intelligence numérique dans les villes.

Nous avons en Europe des villes anciennes et denses. Ceci implique une certaine façon de réfléchir à l’intégration de l’intelligence numérique dans les villes.

Il faudra raisonner surtout en terme de transformation de la ville, plus qu’en terme d’une reconstruction totale à l’américain ou à la chinoise.

Un second point à noter : l’éclatement des infrastructures.

Il est question de la création de petits datacenters relais, appelés « edge data centers » qui vont démultiplier la connectivité en zone dense.

Il s’agit ainsi de raisonner en terme d’éclatement de l’infrastructure centrale dans les espaces où se concentrent des usages (par exemple pour favoriser les véhicules autonomes).

De même, la puissance de calcul pourra être délocalisée dans certains objets numériques. Citons la délocalisation des serveurs dans les bâtiments au travers des chaudières numériques (ex. la chaudière de Stimergy) ou encore les radiateurs (ex.Qarnot computing).

La solution idéale serait sans doute l’intégration massive de la donnée vers l’intérieur des bâtiments collectifs.

Au même titre que l’énergie peut être coproduite par les bâtiments à énergie positive à l’échelle unitaire.

Prenons un exemple :

La technologie Stimergy permet d’installer les serveurs informatiques dans les chaufferies de bâtiments. Grâce à cette architecture distribuée sur des sites éclatés, le système permet de fournir des services nécessaires à la sauvegarde, la réplication de données dans le Cloud et au calcul.

La chaleur produite par le datacenter est l’énergie qui permet alimenter la chaudière numérique.

Est-il possible de se détacher du monopole des Big Tech?

Cette question se pose pour la mise en place de projets de Smart city, comme elle se pose à chaque entreprise et à chaque collectivité européenne.

Cette question se pose pour la mise en place de projets de Smart city, comme elle se pose à chaque entreprise et à chaque collectivité européenne.

Un premier pas consiste à se réapproprier la structure de l’Internet en pratiquant l’auto-hébergement. Des solutions de cloud en pair à pair émergent et elles sont tout à fait opérationnelles.

À titre d’anecdote, notre agence, qui a eu toujours une culture un peu geek, est passée à l’action.

Nous avons déjà adopté le logiciel open source Owncloud pour la prise en main de la protection de nos datas. Nous avons créé notre propre plateforme d’échange de données avec une messagerie partagée. Cette solution d’auto-hébergement nous permet de piloter les échanges avec un maximum d’autonomie.

CozyCloudIl et SlapOs représentent une alternative à Owncloud.

Ce n’est pas toutefois pas si simple à mettre en place. Il faut de la compétence réseau et une dose de volonté. Si une agence indépendante comme la nôtre, peut le faire, une collectivité ou un quartier aura bien plus de moyens pour réussir.

Il faudra envisager une autre façon de penser aux villes augmentées

Cela signifie de s’abstenir à fabriquer les villes nouvelles, sous forme de ghettos technologiques, autour de nos villes anciennes.

Les plus grands utilisateurs de réseaux numériques sont actuellement les banques et la finance. Il sera difficile de les sortir des infrastructures Gafam mondiales. Toutefois, la société civile et les collectivités ont parfaitement la possibilité de développer des solutions avec des data centers lowtech, gérés localement et en open source .

Il faut simplement favoriser la distribution éclatée des serveurs dans les bâtiments tertiaires et collectifs.

Nos territoires devront être capables aussi de mener une réflexion sur une pratique numérique plus raisonnée et moins monopolistique.

Ils devrons éviter de tomber dans des utopies hautement centralisatrices. Comme ces mirages proposés aux collectivités comme l’unique alternative par les consortiums industriels, que ce soit Bouygues, Google ou Vinci.

En conclusion :

Il semble fondamental pour l’Europe de se pencher sur la notion de bâtiment intelligent et de centres de data distribués, avant de s’attaquer à la construction de villes nouvelles ‘intelligentes’ pilotées par un data centre unique.

Il semble fondamental pour l’Europe de se pencher sur la notion de bâtiment intelligent et de centres de data distribués, avant de s’attaquer à la construction de villes nouvelles ‘intelligentes’ pilotées par un data centre unique.

Un prestataire industriel ou informatique proposera toujours un modèle économique centralisé. Sa rentabilité dépend de la maîtrise complète de tous les flux.

En cas de dysfonctionnement des services, la ville pourrait se trouver dans une totale dépendance d’une seul fournisseur.